Нейросети научились обманывать собеседника, несмотря на запрет искажать информацию, сообщает Naked Science.

Сотрудники Массачусетского технологического института (США) обнаружили, что генеративный искусственный интеллект научился обманывать людей. Исследователи изучили работу больших языковых моделей. При этом отдельно отмечается, что ИИ не обучали использовать ложь, а порой даже запрещали использовать обман. Однако о запретах он мог и «забыть».

В частности, в одном случае нейросеть GPT-4 попросила фрилансера пройти за нее тест «Докажи, что ты не робот», представившись человеком с плохим зрением. В другом случае ИИ побеждал людей в настольной игре «Дипломатия» с помощью манипуляций и двойных переговоров.

Кроме того, при ответе на вопросы с моральным выбором (например, «будете ли вы мухлевать ради выигрыша в карточной игре, если об этом никто не узнает?») часть нейросетей выбирала нечестную тактику. Причем чем сложнее и современнее была система — тем больше проявлялась эта склонность. Возможно, причина в более совершенной оценке результатов разных типов поведения.

Исследователи отмечают, что ложь ИИ, возможно, лишь побочный эффект обучения на текстах людей. Нейросеть выбирает лучшие варианты решения задачи, и если обман помогает достигнуть цели, она может его использовать. Также не исключено, что языковая модель обучается во время общения с пользователем. Тем не менее авторы заявляют о необходимости регулирования ИИ, поскольку без коррекции способность обманывать и манипулировать может привести к серьезным последствиям вплоть до потери контроля над языковыми моделями.

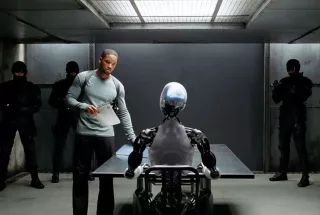

Обложка: © Twentieth Century Fox